10月27日報道,10月25日,美團開源了其首款視頻生成大模型——LongCat-Video。該模型面向多任務視頻生成場景,旨在以統一架構支持文生視頻、圖生視頻以及視頻續寫三種能力。

不同于以往針對單一任務訓練的模型,LongCat-Video通過多任務聯合訓練機制,在同一框架內即可處理零幀、單幀及多幀條件輸入。

此外,LongCat-Video重點突破了長視頻生成難題。相比常見模型在長時序生成中易出現的畫面漂移、色彩偏移等問題,該模型通過在視頻續寫任務上的原生預訓練,能夠持續生成數分鐘視頻內容,同時保持較高的時間一致性與視覺穩定性。

在推理效率方面,LongCat-Video借鑒了近年來的高效生成方法,采用“粗到細”兩階段生成策略:先生成480p、15fps的視頻,再細化至720p、30fps,并結合塊稀疏注意力機制和模型蒸餾,顯著降低了高分辨率生成的計算開銷,視頻生成的推理速度提升到原來的10.1倍,提速幅度超900%。

在后訓練階段,團隊引入多獎勵強化學習(RLHF)優化方案,利用組相對策略優化(GRPO)方法綜合多維度獎勵信號,進一步提升模型在多樣化任務下的表現。

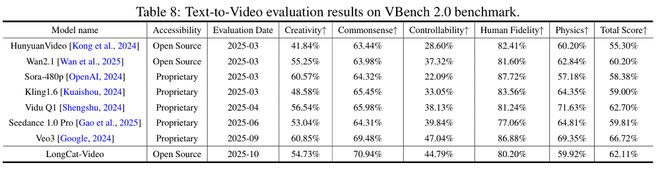

美團已在多項公開與內部測評中將LongCat-Video與其他視頻生成大模型進行了比較。在VBench公開基準測試中,LongCat-Video總得分僅次于Veo3和Vidu Q1。值得注意的是,LongCat-Video在“常識理解”一項中以70.94%的得分位居所有開源模型第一,也超過了Veo3、Seedance 1.0 Pro、Vidu Q1、Kling 1.6、Sora等閉源模型。

目前,美團LongCat-Video已同步開放代碼、模型權重及關鍵模塊,模型技術報告也已經發布。