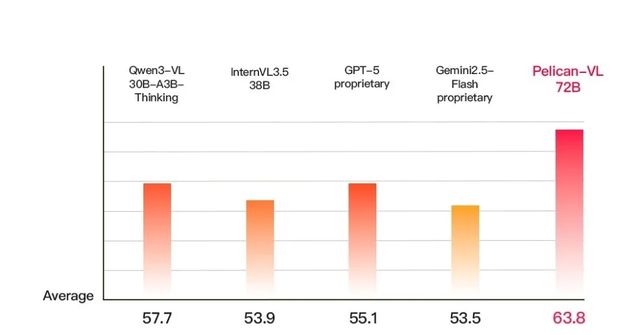

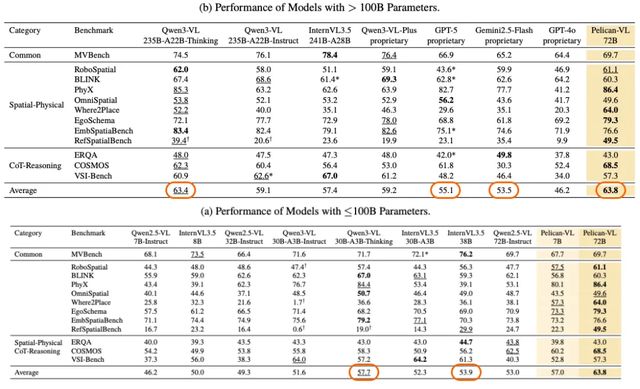

11月13日,北京人形機(jī)器人創(chuàng)新中心全面開源具身智能VLM模型——Pelican-VL 1.0。該模型覆蓋7B、72B參數(shù)規(guī)模,是迄今為止“最大規(guī)模的開源具身多模態(tài)大模型”,同時(shí),也是迄今為止全球性能最強(qiáng)大的具身智能VLM模型,根據(jù)測(cè)試,其性能超越GPT-5 同類模型15.79% ,與Google gemini 系列模型相比提升19.25%,同時(shí)也超越通義千問、書生萬象等國內(nèi)模型,成為了目前最強(qiáng)的開源具身多模態(tài)大模型 。

另外值得注意的是,Pelican-VL的核心主創(chuàng)團(tuán)隊(duì)都是由女性組成,這也充分體現(xiàn)了女性力量在我國科技研發(fā)中的重要貢獻(xiàn)。該團(tuán)隊(duì)還提出了一套全新的DPPO(刻意訓(xùn)練)訓(xùn)練范式,是全球首創(chuàng)的具身多模態(tài)大模型后訓(xùn)練自進(jìn)化算法框架。憑借DPPO,Pelican-VL 實(shí)現(xiàn)【性能最強(qiáng)】這一目標(biāo)使用的數(shù)據(jù)量為200K,僅僅是其他大模型的1/10甚至1/50,是名副其實(shí)的開源VLM性價(jià)比之王。

Pelican-VL 1.0 的開源,能夠大幅提升具身智能在商業(yè)服務(wù)、工業(yè)泛工業(yè)、高危特種作業(yè)、家庭服務(wù)等多種真實(shí)場(chǎng)景中,通過視覺-語言感知輔助多步任務(wù)規(guī)劃的能力。而VLM作為目前實(shí)現(xiàn)機(jī)器人全自主的核心,Pelican的開源也將推動(dòng)我國具身智能全自主發(fā)展。

本次開源的Pelican-VL 1.0的核心優(yōu)勢(shì)在于深度整合海量數(shù)據(jù)與自適應(yīng)學(xué)習(xí)機(jī)制,在由 1000+ A800 GPU 組成的集群上訓(xùn)練,單次檢查點(diǎn)訓(xùn)練耗費(fèi)超過 50,000 A800 GPU-小時(shí);團(tuán)隊(duì)從原始數(shù)據(jù)中蒸餾出的包含數(shù)億 token 的高質(zhì)量元數(shù)據(jù)以做訓(xùn)練基石。基于上述優(yōu)勢(shì),Pelican-VL 1.0實(shí)現(xiàn)了在基線基礎(chǔ)上性能提升20.3%,平均超過Qwen3-VL系列、InternVL3.5系列等同級(jí)別開源模型10.6%。

得益于“刻意練習(xí)”DPPO(Deliberate Practice Policy Optimization)訓(xùn)練范式,Pelican-VL 就像一名刻苦鉆研的學(xué)生:每次訓(xùn)練循環(huán)都會(huì)“看視頻—自主練習(xí)—發(fā)現(xiàn)錯(cuò)誤—糾正提升”。通過DPPO 模仿人類元認(rèn)知的學(xué)習(xí)方式,通過強(qiáng)化學(xué)習(xí)(RL)探索弱點(diǎn)、生成失敗樣本,再進(jìn)行有針對(duì)性的監(jiān)督微調(diào)(SFT),讓模型不斷自我糾錯(cuò)和迭代進(jìn)步。

就像學(xué)生做錯(cuò)題后總結(jié)經(jīng)驗(yàn)一樣,Pelican-VL 能在訓(xùn)練中發(fā)現(xiàn)“薄弱知識(shí)點(diǎn)”并補(bǔ)齊,從而持續(xù)提高在視覺-語言和具身任務(wù)上的能力。通過這種機(jī)制,Pelican-VL 能夠更準(zhǔn)確地理解圖像內(nèi)容、語言指令和物理常識(shí),最終在決策和操作執(zhí)行環(huán)節(jié)中,實(shí)現(xiàn)了具身智能在空間-時(shí)間推理和動(dòng)作規(guī)劃方面的大幅突破。

VLM,讓具身擁有智能

人形機(jī)器人無疑是目前AI技術(shù)在普通人認(rèn)知里最具象的展現(xiàn),而讓機(jī)器人真正能夠做到服務(wù)人類,一直都是全球研發(fā)團(tuán)隊(duì)所追求的目標(biāo),但這并不容易,背后是具身智能體對(duì)于空間-時(shí)間的理解不足,以及多步驟長線程復(fù)雜決策的能力缺失造成的困境。

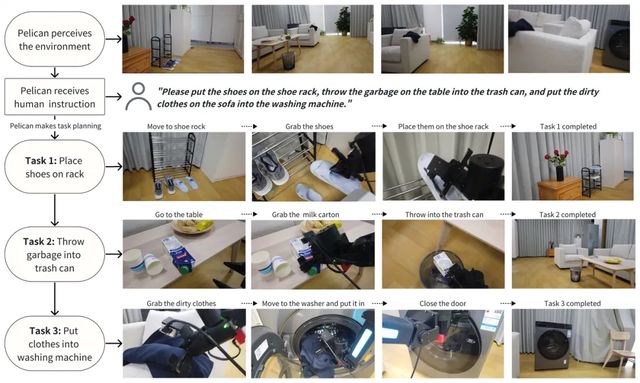

在典型的Vision–Language–Action (VLA) 系統(tǒng)里,Pelican-VL 扮演著“視覺語言大腦”的角色,為機(jī)器人提供強(qiáng)大的環(huán)境感知和指令理解能力。它將攝像頭所見與自然語言指令結(jié)合,構(gòu)建起對(duì)場(chǎng)景的多模態(tài)表征,然后輸出可供后續(xù)決策單元使用的結(jié)構(gòu)化信息。也就是說,Pelican-VL負(fù)責(zé)“看圖聽話”,理解指令和環(huán)境,VLA負(fù)責(zé)跨機(jī)器人應(yīng)用;簡而言之,Pelican-VL 構(gòu)成了VLA系統(tǒng)的認(rèn)知前端,為長期規(guī)劃和指令執(zhí)行提供跨模態(tài)的信息支持,使機(jī)器人能夠像人類一樣將復(fù)雜任務(wù)拆解并落地操作。

而由于端到端VLA直出的模型存在黑箱性,機(jī)器人雖然可以理解人類指令,但最終執(zhí)行的動(dòng)作卻不可控,而分層的模型則是先建模、再規(guī)劃、最后執(zhí)行,雖然解決了黑箱風(fēng)險(xiǎn),但也產(chǎn)生了新的信息傳導(dǎo)誤差問題,信息隨著每一層模型的傳遞,可能會(huì)在某一層產(chǎn)生微小誤差,這一誤差會(huì)在后續(xù)環(huán)節(jié)呈現(xiàn)指數(shù)級(jí)的擴(kuò)散。

北京人形的解法是讓VLM和世界模型相互糾偏作為大腦,再與VLA等構(gòu)建的技能庫模型協(xié)作。通過將VLM部署在云端,用于理解指令、規(guī)劃任務(wù)與生成策略,世界模型則對(duì)物理世界進(jìn)行建模與預(yù)測(cè),VLM規(guī)劃的策略在世界模型中進(jìn)行預(yù)演,預(yù)測(cè)執(zhí)行策略后的結(jié)果。二者通過反饋機(jī)制相互作用,具象化的理解策略的后果,根據(jù)好壞精進(jìn)能力,VLM能力提升后又反向修正和提升世界模型的預(yù)測(cè)準(zhǔn)確性,以此幫助機(jī)器人實(shí)現(xiàn)能力躍遷的關(guān)鍵。

以下面這個(gè)復(fù)合指令為例:“把鞋子放到鞋架上、將桌上的垃圾扔到垃圾桶,再把衣服放入洗衣機(jī)”。Pelican-VL 首先將會(huì)感知房間物體和布局,構(gòu)建出整個(gè)環(huán)境的語義表示;接著根據(jù)指令自動(dòng)生成行動(dòng)序列:依次移動(dòng)到鞋架、垃圾桶和洗衣機(jī)位置并進(jìn)行抓取和放置操作。

作為創(chuàng)造全球首個(gè)人形機(jī)器人馬拉松冠軍的團(tuán)隊(duì),北京人形致力于讓具身智能體從最能跑到最聰明、最好用的演進(jìn),本次Pelican-VL的開源也代表著北京人形在具身智能領(lǐng)域的又一重大突破。

而Pelican-VL代表了國內(nèi)具身智能的一種端到端解法,它和Google提出的RT-2有著相似特點(diǎn),都是追求單模型解決感知到執(zhí)行,但不同于RT-2基于PaLM-E、PaLI-X等預(yù)訓(xùn)練模型微調(diào)的思路,Pelican-VL是從零開始構(gòu)建大規(guī)模具身訓(xùn)練集并使用DPPO循環(huán)自我演練,而與SayCan、GPT-5相比,它則更強(qiáng)調(diào)開放性和端到端的控制輸出,為不同機(jī)器人提供統(tǒng)一的智能“大腦”解決方案。

因此,Pelican-VL不僅具備目前具身智能大模型里最大的規(guī)模、最強(qiáng)的性能,也能夠幫助人形機(jī)器人更好的感知空間-時(shí)間、實(shí)現(xiàn)具身交互,并且在訓(xùn)練中進(jìn)行自我糾錯(cuò)與迭代。

開源當(dāng)天,北京人形進(jìn)行了直播演示和技術(shù)解讀,邀請(qǐng)了《商業(yè)漫談 Jane’s Talk》創(chuàng)始人、科技媒體人衛(wèi)詩婕與主創(chuàng)成員深度對(duì)話,不僅詳細(xì)展現(xiàn)了具身智能大腦Pelican-VL全面領(lǐng)先的性能,并拆解Pelican-VL創(chuàng)新的技術(shù)架構(gòu),還充分展示了女性研發(fā)成員在具身智能模型領(lǐng)域的創(chuàng)新力量。

用“最低”的門檻,激發(fā)“最高”的產(chǎn)業(yè)活力

北京人形希望通過Pelican-VL 的開放為產(chǎn)業(yè)落地提供更良好土壤,讓廣大機(jī)器人廠商和開發(fā)者可以自由使用與定制這一模型,加速研發(fā)進(jìn)程。例如,北京人形機(jī)器人創(chuàng)新中心還在推進(jìn)“千臺(tái)機(jī)器人真實(shí)場(chǎng)景數(shù)據(jù)采集計(jì)劃”,讓上千臺(tái)機(jī)器人在工廠、倉庫、酒店等場(chǎng)景中執(zhí)行任務(wù)并采集數(shù)據(jù)。而這些規(guī)模化的多模態(tài)數(shù)據(jù)與Pelican-VL結(jié)合,將推動(dòng)其在制造業(yè)自動(dòng)化、智能物流、零售無人化和家居服務(wù)等多領(lǐng)域的快速適配和優(yōu)化。

Pelican-VL 的開源特點(diǎn)和多場(chǎng)景覆蓋能力可以視作機(jī)器人生態(tài)的“開放型大腦”,作為具身智能的基礎(chǔ)軟件平臺(tái),廠商可以基于它快速開發(fā)特定場(chǎng)景下的應(yīng)用方案,大大降低開發(fā)成本和難度。長期來看,Pelican-VL 及其后續(xù)版本將促進(jìn)國內(nèi)形成完善的通用機(jī)器人智能平臺(tái),推動(dòng)更多種類的機(jī)器人像安裝“通用智能操作系統(tǒng)”一樣迅速獲取新能力。

Pelican-VL 1.0 的開源標(biāo)志著具身智能進(jìn)入了一個(gè)以數(shù)據(jù)驅(qū)動(dòng)、開放協(xié)同為核心的新階段。它不僅在技術(shù)上實(shí)現(xiàn)了視覺、語言和行動(dòng)的深度融合,也為產(chǎn)業(yè)鏈帶來了全新的合作模式。隨著更多研究機(jī)構(gòu)和企業(yè)參與生態(tài)建設(shè),北京人形致力于通過通用機(jī)器人“大腦”市場(chǎng)的發(fā)展,讓更多機(jī)器人在可見的未來中具備“通用智能”、靈活自適應(yīng)的能力。